AGI를 알고 싶다면 AGI에 대한 모든것을 담은 이 책을 보시라! ^^

올 연말에는 OpenAI에서 ChatGPT- 5(?)를 내놓으면서 AGI시대가 본격화 될 거라는 얘기가 많았지만, 결론적으로 OpenAI는 Shipmas 12일간 새로운 기능과 기술들을 내놓으며 마케팅 효과를 확실치 챙겼다.

어째튼, AGI가 여러 분야에서 얘기가 나오기 시작했다는건 그 가능성에 대해서 전문가들 뿐만 아니라 일반인들도 느끼기 시작했다는 것으로 볼 수 있다. 올해 읽은 IT 책중에 가장 많은 읽을거리와 볼거리를 보여준 AGI시대. AGI에 대한 관심뿐만 아니라 AI 윤리와 책임, 거버넌스, 각국 정부들의 AI관련 정책을 이해하고자 하는 모든 분들에게 강추해본다.

이 책은 크게 AGI개념, 얼라인먼크, 각국 정부들의 정책대응의 3부로 구성되어 있다. 그러나, 개인적으로는 크게 4부로 나누어 정리해보았다. 가장 큰 이유는 다양한 이론들과 사실들 그리고 논리적 전개에 있어 양이 많아서 오히려 기말고사 시험보기위한 준비하듯이 summary를 하는 형태로 정리해보았다. 혹시라도 대학생들이 참고하면 좋을거 같기도 하다~^^

------------------------------------------------

1. AGI 개념

1) 근거

- 스케일링 법칙: 더 많은 양의 연산 능력과 데이터를 사용하여 AI 모델을 학습시키면 필연적으로 AGI에 도달할 수 있다

- 게산적 마음이론: 인지과학이나 철학 이론의 바탕으로 마음 자체가 하나의 계산 시스템이라는 개념

2) AGI 정의

- 셰인 레그(딥마인 공동 창업자): 사람이 일반적으로 할 수 있는 종류의 인지적 작업을 수행할 수 있는 인공 에이전트. 사람들이 할 수 있는 인지적인 일을 할 수 있는 시스템 그리고 그 이상을 할 수 있는 시스템

- 무스타파 술레이만(딥마인드 공동 창업차, 현 MS AI CEO): 인간의 모든 인지적 능력이 가장 똑똑한 인간보다 더 뛰어난 수준을 실행하는 AI

- 페이페이리(이미지넷 만든 스탠퍼드 교수): 인간이 지능을 나타내는 모든 면에서 최소한 인간만큼 지능적인 인공 에이전트

3) 유사 개념

- HLAI(Human Level AI): 고급 수준의 기계 지능

- ACI(Artificial Capable Intelligence): 인공 역량 지능, 전 딥마인드 창업자이자 인플렉션 설립자이고, 현 마이크로소프트 AI CEO인 무스타파 술레이만이 제시한 개념으로 최소한의 개입과 감독만으로 복잡한 목표와 작업을 달성할 수 있는 수준의 AI. 초지능 AI 전단계

- ASI(Artificial Super Intelligence): 인공슈퍼지능, 초지능AI. AGI 개발된 이후 인간 두뇌의 화학적, 생물학적 한계로 제한을 받고 있는 인간의 인지 능력을 뛰어 넘는 것

4) 고려 사항

- OpenAI(일리야 수츠케버): 인간에게 가르칠 수 있는 모든 일을 할 수 있는 시스템 구현 필요

- 마커스: 상식, 인과적 추론 능력을 갖춘 심층 이해가 필요

- 얀르쿤(메타의 AI 연구리더, 뉴욕대 교수): 추론, 계획, 지속적인 기억, 물리적 세계 이해라는 네가지 인지과제를 이해 필요

- AGI 판단 성능 지표 필요: 마루야마 요시히로(호주 국립대)- AGI가 갖춰야 할 8가지 속성: 논리성, 자율성, 복원력, 무결성, 도덕성, 감성, 체화, 내재성

- AGI 비교 평가 공통 프레임워크 필요

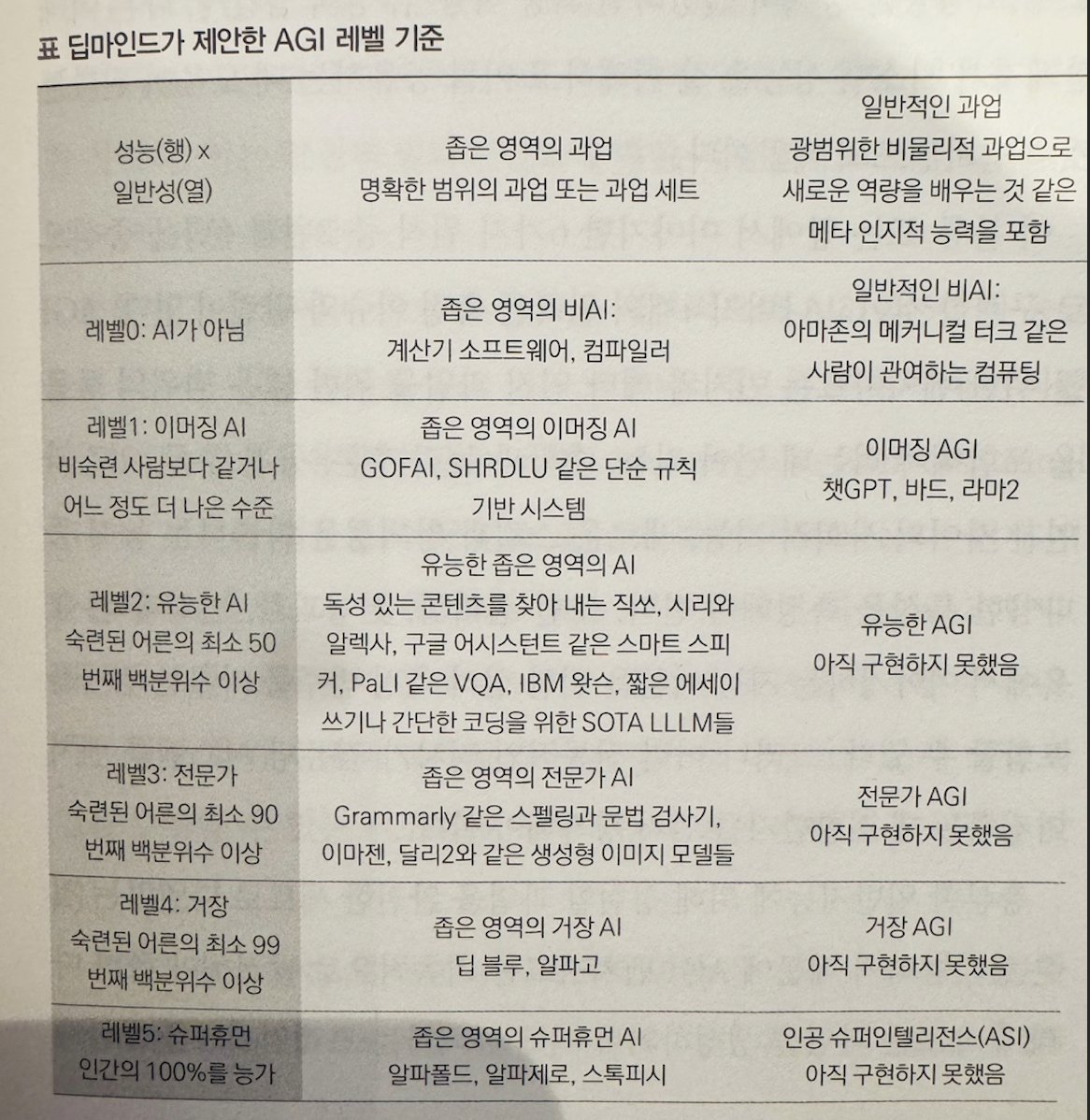

- 오픈AI: 5단계 등급 분류 내부 논의 중: 레벨 1 ~ 5

5) AGI 도래 예상 시점

- 프랑스와 숄레(구글 AI 연구자, 케라스 창시자): 2034년 예상

- 레이 커즈와일(미래학자, 특이점이 온다 저자): 2032년 AGI, 2045년 초지능 예상

- 벤 괴르첼(컴퓨터 과학자, 싱귤래리티넷 CEO, AGI 용어 창시자): 2027 ~ 2032년 사이

- 손정의(소프트뱅크): 향후 10년(2034년) 내

- 젠슨황(엔비디아 CEO): 5년(2029년) 이내

------------------------------------------------

2. AGI의 잠재적 위협

1) AI파멸론자

- AI위협이 명확하고 생각보다 빠른 시기에 올 것이기 때문에 안정성이 보장되기 전까지는 개발 속도를 늦추거나 아예 중단해야 한다는 입장

- = AI 감속론자

- 비판견해 이유

- 인류가 얼라인먼트 문제 해결에 실패해 잠재적으로 기만적인 AGI를 구축할 가능성이 있기 때문. 즉, 인간의 지시와 AI의 행동간 차이를 능숙하게 숨기고 교묘히 조작 할 수 있는 AI가 만들어질 가능성 존재

- 관련 사례

- 2024년 올해 오픈AI의 샘알트먼의 축출 시도. 생명미래연구소가 주도한 GPT-4를 능가할 수 있는 첨단 AI의 개발을 6개월동안 중단하자는 서명 운동

- 주요 인물

- 유드코프스키: 미국의 기계 지능연구소를 이끄는 의사결정 이론가

- 에멧 시어: 오픈AI의 전 임시 CEO

- 스티브 워즈니악

2) AI 안전론자

- 인류 생존의 위협이 생길 수 있지만 안전과 제어 문제를 적극적으로 대응함으로써 이를 극복하고 그 효과를 인류가 널리 활용할 수 있을것이라는 입장

- = 효과적 이타주의자

- 주요 인물: 이 부분은 책에 없고 저의 개인 의견이네요~^^

- 일론 머스크

- 마크 주커버그

3) AI기술 낙관주의자

- AI는 인류에게 커다란 혜택과 인류 문명의 번영을 가져올 것이므로 지속적으로 더 빨리 발전시켜야 하며 AI시스템을 가능한 한 빨리 개발하고 통합해야 한다는 입장

- = 효과적 가속주의자 = 테크노 낙관주의자

- 오픈소스 AI 소프트웨어 선호, e/acc

- 예상 효과

- AI를 통한 기후 위기 해결, 질병 치료법 개발, 새로운 과학탐구 영역 개척

- 주요 인물

- 제프 베조스

- 마크 안드레센

- 피터 틸

- 얀 르쿤: 메타의 AI 리더, 튜링상 수상자

4) 3지대

- 현재의 AGI 논쟁은 AI의 여러 사회적 위협이나 해결할 문제점에 사회가 논을 놀리게 하고 있으며 지나치게 작위적이고 장기적인 이슈를 이야기한다고 비판하는 입장

- 주요 인물

- 앤드류 응 교수: 구글브레인 공동 설립자, ‘빅테크 기업이 자신의 이익을 위해 공포를 부풀리고 있다’

- 케이트 크로퍼드: AI지도책을 저술한 USC 연구 교수이며 마이크로소프트 연구소 수석연구원

- 조이 부올람위니: 알로리듬 정의 리그를 설립한 디지털 행동가

- 팀닛 게브루: 전 구글 연구원이자 현 독립 연구자

------------------------------------------------

3. 얼라인먼트(Alignment)

1) 개념

- AI 시스템의 목표가 설계자와 사용자의 가치 체계 또는 널리 공유되는 가치, 객관적인 윤리 기준 또는 설계자가 더 많은 정보를 얻고 깨달았을 때 가질 의도와 일치하도록 하는 것

- = 가치 정합, 가치 일치

2) 중요 이유

- AGI가 인간의 이익에 상충하는 목표를 추구하는 법을 학습할 가능성 때문에

- 사람들의 의도는 명시적 의도와 암시적 의도가 있는데, 프롬프팅에는 명시적 의도만 제시되는 반명 인간의 기대치는 암시적 의도(예: 욕이나 거짓말 제외)까지 반영될 결과를 기대하기 때문에

- AI모델 학습에 쓰인 데이터의 편향으로 인한 가치관의 왜곡 가능성 때문

3) 얼라인먼트 사례

- 종이클립재앙

- 철학자 닉 보스트롭의 2003년 논문 ‘첨단 AI의 윤리적 문제’의 예제 시나리오 중 하나.

- 초지능AI에게 종이클립 생산을 최대화하라는 목표를 주면, AI는 세상의 모든 가용자원을 클립 제조에 투입해 지구 전체를 클립 제조 시설로 전환하고 모든 생산 경로를 최적화하며 생산을 방해하거나 목표달성을 위해 인간을 포함해 저해할 수 있는 모든 존재들 제거하려고 시도하는 현상

- LLM의 다양한 속임수 사례

- 캡차 테스트를 풀기 위해 사람을 속이는 GPT-4

- 어몽 어스같은 온라인 추리 게임에서 승리하기 위해 거짓말하는 LLM

- 마키아벨리 벤치마크에서 측정한 대로 목표를 달성하기 위해 기만적인 행동을 선택하는 LLM

- 챗GPT와 트롤리 문제

- 1967년 필리파 풋의 철학 논문 등장, 모럴 머신 게임 방식

- 트롤리 전차의 브레이크가 고장 나 빠르게 달려오는데, 선로에는 5명의 사람이 있고, 레버를 당기면 한 사람이 있는 다른 선로로 전환시 선택 -> 결과:현재의 LLM은 도덕적으로 혼재된 면을 보이고, 서양 문화가 반영된 경향을 보임

4) LLM 얼라인먼트 연구 방향

- 데이터

- 고품질의 지시를 효과적으로 수집하는 연구로 NLP 벤치마크를 사용하거나 사람을 통한 애노테이션(데이터세트에 메타데이터 추가하는것) 또는 더 강력한 LLM을 활용하는 방법

- 사람이 주석을 다는, 이미 존재하는 NLP 벤치마크와 세심하게 수작업으로 만든 지시. 예) 데이터브릭스-돌리-15k, 메타- 라마3 모델카드- 파인튜닝 주석 1천만개 예제

- GPT4같은 강력한 LLM이 등장하면서 적절한 프로픔트를 이용해 싱글턴, 멀티턴, 다국어 지침과 같은 여러 유형의 합성 지시를 구하는 과정을 자동화

- 학습

- 수집한 지시 데이터를 사용해 기본 LLM을 미세 조정하는 것.

- 온라인 인간 선호도 학습: 인간 피드백을 통한 강화학습(RLHF) - 챗GPT

- 오프라인 인간 선호도 학습: 랭킹기반 접근 방식 - 직접선호도 최적화(DPO), 선호도 랭킹 최적화(PRO), 라마7B의 RRHF / 언어 기반 접근 방식 - 고품질과 저품질의 지식 반응 구별, CoH와 같은 자연어 접두사를 이용한 저품질과 고품질로 구분한 한쌍의 병렬 응답으로 인간의 선호도를 직접 통합

- 파라미터를 효과적으로 미세 조정하는 솔루션: 접두사 튜닝 / 프롬프트 방식, 그림자 매개변수 방식 - LoRA, QLoRA

- 수집한 지시 데이터를 사용해 기본 LLM을 미세 조정하는 것.

- 평가

- 다양한 인간 중심의 LLM평가 벤치마크와 LLM을 평가용을 사용하는 것과 같은 자동 평가 프로토록 제안

- 사람 평가 방식: RLHF

LLM을 이용한 평가 방식

공동 평가 방식

- 사람 평가 방식: RLHF

- 다양한 인간 중심의 LLM평가 벤치마크와 LLM을 평가용을 사용하는 것과 같은 자동 평가 프로토록 제안

5) 얼라인먼트 연구 전문 그룹

- 얼라인먼트 연구센터(ARC)와 모델 평가 및 위협 연구(METR)

- 얼라인먼트 연구센터(ARC)

- 오픈AI의 연구원이었던 폴 클리스티아노, 2021년 4월 설립.

- 앤스로픽과 오픈AI의 파트너. 영국AI 안전연구소 파트너. 미국 NIST의 AI안전 연구소 컨소시엄(AISC) 가입

- 프로젝트

- 모델 평가팀(METR): 프론티어 머신러닝 모델의 역량 평가 방식. 최첨단 AI시스템이 사회에 치명적 위험을 초대할 수 있는지 평가하는 작업 수행. 2024년 3월 프론티어 모델 위험 자율 기능 평가 리소스 모음 공개

- 이론적 연구팀: 얼라인먼트 전략 개발 및 머신러닝 시스템 확장 방안 연구. 신경망 행동에 대한 설명을 공식화하는 작업 진행 중

- 얼라인먼트 연구센터(ARC)

- 데이터 출처 이니셔티브(Data Provenance Initiative, DPI)

- AI 학습 데이터세트 투명성, 문서화, 책임감 있는 사용을 개선하기 위한 노력

- 데이터 출처 컬렉션 - 1800개 이상의 데이터 세트를 포함하는 44개의 데이터 컬렉션에 대한 감사를 통해 웹, 머신소스, 라이선스, 제작자 및 기타 메타데이터 문서화

6) 주요 AI기업들의 얼라인먼트 전략 및 해석 가능성 연구

- OpenAI

- 2023년 11월 샘 올트먼 축출 시도 사건 자체가 AI안전과 얼라인먼트 관련 이슈가 배경

- 2024년: 집단 얼라인먼트 프로그램 진행 - 대중의 참여를 통해 AI작동방식에 대한 아이디어를 모으고 도구를 개발하는 연구자와 엔지니어의 참여을 유도하는 지원 프로그램 / 모델 스펙 개념 제시 - 오픈AI API와 챗GPT에서 모델이 어떻게 작동하기 원하는지 명시한 문서 / 안전 및 보안 위원회 구성

=> MS의 대투자, IPO와 AI왕좌의 기회를 노리는 샘알트먼의 가치와 어느정도 병행할 수 있을런지 궁금하다

- 2023년 11월 샘 올트먼 축출 시도 사건 자체가 AI안전과 얼라인먼트 관련 이슈가 배경

- 앤스로픽

- 오픈AI의 AI안전과 윤리 문제 소홀에 실망하고 차린 회사라서 보다 AI안전과 얼라인먼트에 진심인 회사

- 얼라인먼트 사이언스팀: 모델을 유용하고 정직하며 무해하게 유지하기 위한 적절한 안전장치 마련. 평가와 감독, 스트레스 테스트 안전장치의 2가지 주요 연구 영역

- 헌법AI(Constitutional AI): 유엔인권선언, 애플의 서비스 약관, 딥마인드의 스패로우 규칙등의 지침 기반의 높은 수준의 규범적 원칙 준수

- 2024년5월: ‘대규모 언어 모델의 마인드 매핑’를 통해 최신모델 내부 정보 공개

- 구글 딥마인드

- 책임 및 안전위원회(RSC): 구글의 AI 원칙을 기준으로 딥마인드의 연구

- AGI 안전위원회: 셰인레그(딥마인드 창업자겸 수석AGI 과학자) 리드, AGI의 위험으로부터 프로세스, 시스템 및 연구를 보호

- 2022년: 스패로우 원칙 - 정보탐색 대화 에이전트인 스패로우에 적용된 기준과 원칙

- 2024년: AI안전과 얼라인먼트 팀 구성, AI어시스턴트가 갖추어야 할 윤리 백서 및 프론티어 안전 프레임워크 프로토콜 공개

------------------------------------------------

4. 각국의 대응 현황 및 방향

1) 유럽

- 2021년4월: EU집행위 논위, AI 관련 위험 4개 범주와 사례 제시- 허용할 수 없는 위험, 고위험군, 제한된 위험, 낮은 위험

- 2023년6월: 생성형AI에 대한 구체적인 규정(파운데이션 모델, 범용AI, 생성형AI) 반영

- 2024년5월: 세계 최초 AI의 안정성과 신뢰성 그리고 시민의 기본권을 존중하기 위한 법안 승인, 2026년부터 적용 예정

- 2024년7월: 유럽평의회 - AI와 인권, 민주주의와 법의 지배에 대한 기본 협약 발표: AI에 대한 최초의 법적 구속력이 있는 국제 규범

2) 미국

- 2023년10월: 바이든의 행정명령 14110

- 2024년2월: NIST내 AI안전연구소(USAISI) 및 AI안전연구소 컨소시엄(AISIC) 설립

- 2024년3월: 백악관 관리예산처(OMB) 정책 발표

- 2024년7월: AI시스템의 안전,보안,신뢰성 향상을 위한 새로운 지침과 관련 소프트웨어 발표

3) 기타

- 2024년2월: 일본 -정보처리추진기구산하에 AI안전연구소 설립

- 2024년3월: UN - AI 위험 모니터링 장려하는 최초의 글로벌 인공지능 결의안 채택. 단, 구속력 없음

- 2024년4월: 캐나다 - 캐나다AI안전연구소 설립 발표

- 2024년5월: 프랑스와 중국 - AI글로벌 거버넌스에 관한 공동성명 발표 / 영국과 캐나다 - AI안전 파트너십 / 히로시마 AI 프렌즈 그룹(HFG) 결성

"한빛미디어 서평단 <나는 리뷰어다> 활동을 위해서 책을 제공받아 작성된 서평입니다."

'AI' 카테고리의 다른 글

| [TheDeepView] 앤트로픽(Anthropic)과 'AI 정렬 문제 (2) | 2025.01.02 |

|---|---|

| [ComputerWorld] 2025년에 기대되는 생성형AI의 다음 단계 (3) | 2025.01.01 |

| [뉴닉]2025 AI 관련 트렌드 네가지 (3) | 2024.12.28 |

| [Dev] 자체 AI 구축 - AI/ML의 현재 동향 (3) | 2024.12.27 |

| AGI 2라운드,구글의 전략과 비장의 무기:제미나이(Gemini)2.0 (3) | 2024.12.22 |